Как закрыть сайт от индексации в robots.txt

В данной инструкции разберемся с 2 основными вопросами: зачем закрывать сайт от индексации и как это сделать с помощью файла robots.txt.

Зачем закрывать сайт или страницу от индексации

В каких ещё ситуациях нужен запрет на индексацию:

1. Открытие сайта для пользователей, когда он еще не оптимизирован. После релиза сайта его страницы сканируются роботами при первом обходе. Однако если дизайн и контент страниц пока ещё не оптимизированы для продвижения, рекомендуется на время доработок закрыть

2. Тестирование сайта на другом домене. Если вы создали аналог основного сайта и проводите на нём тестовые работы, поисковые роботы могут воспринять страницы сайтов как дубликаты. В результате основной сайт может потерять позиции.

3. Смена дизайна, параметров, контента. На время работ по улучшению интерфейса и юзабилити закройте страницы сайта от индексации полностью или частично.

Запрет на сканирование — часто временное явление. После окончания технических работ вы сможете вернуть сайт в прежнее состояние. Такой шаг помогает сохранить позиции в выдаче.

Как закрыть сайт от индексации через robots.txt

Файл robots.txt позволяет запретить индексацию страниц, разделов или всего сайта. Используйте директиву Disallow в качестве команды для поисковых роботов.

1. Если нужно закрыть весь сайт от всех роботов, пропишите в файле robots.txt:

User-agent: * Disallow: /

2. Если требуется закрыть от индексации определённые разделы, укажите их после директивы Disallow. Для каждого типа контента используйте отдельную директиву.

Пример:

User-agent: * Disallow: /catalogs Disallow: /news

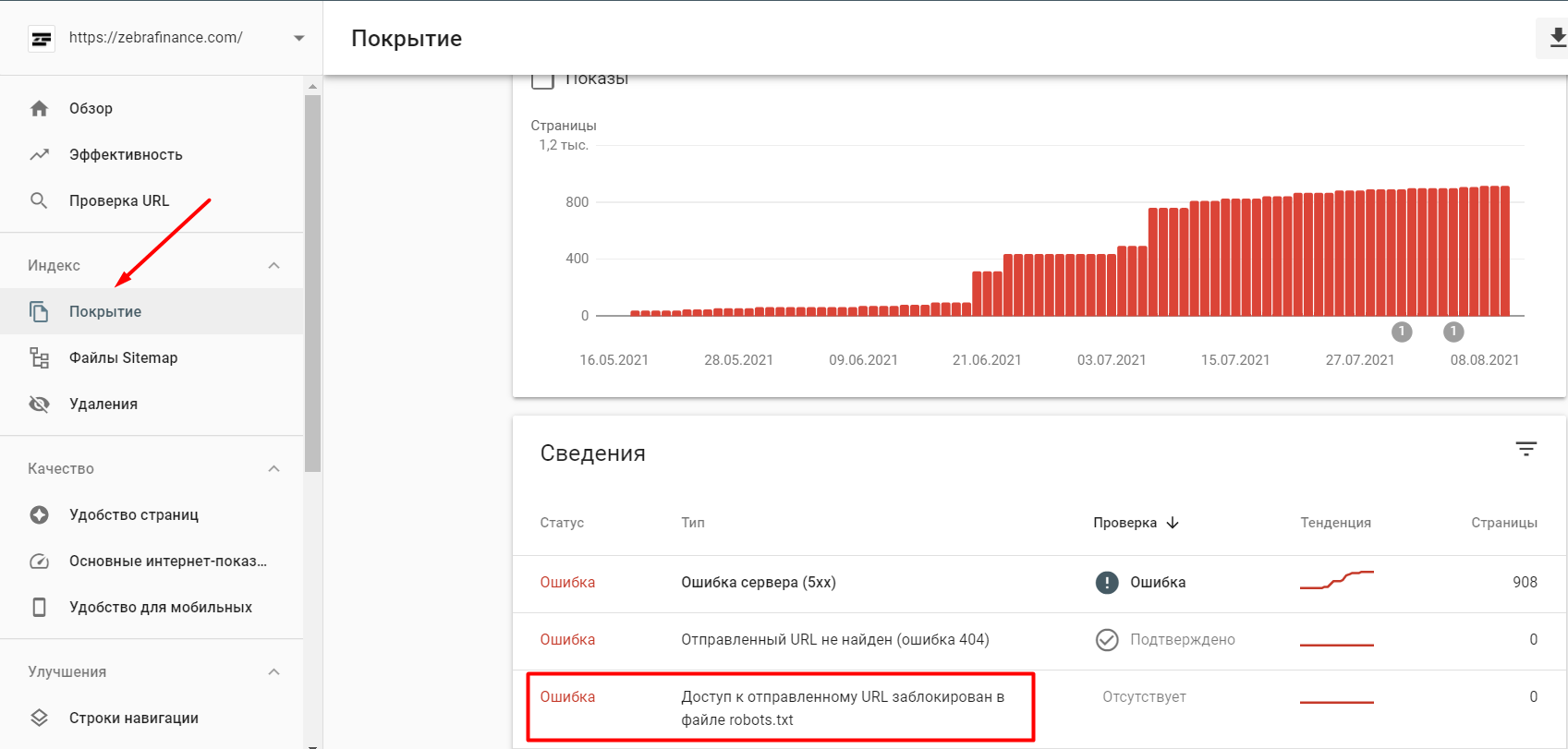

Многие SEO-оптимизаторы отмечают, что Google часто игнорирует директиву Disallow и продолжает индексировать все страницы сайта. Проверить это можно в Google Search Console.

Если страница закрыта от индекса в robots.txt, но это не указано в панели вебмастеров, скорее всего, Google-бот продолжит индексировать эту страницу.

Если директива Disallow в robots.txt не помогает закрыть страницу от индексации, то нужно использовать другие методы.

При проведении технических работ желательно временно закрыть сайт от индексации. Так вы сможете работать над дизайном и юзабилити без ущерба для поисковой оптимизации.

Похожие вопросы

Похожие вопросы

-

Google Search Console

Как работать в Google Search Console. Советы и рекомендации12 вопросов -

SEO пузомерки

Ключевые метрики SEO: где и как смотреть6 вопросов -

Линкбилдинг

Все про построение ссылочного профиля, крауд-маркетинг и аутрич10 вопросов -

Для опытных

Вопросы для продвинутых SEO-специалистов и новые подходы в SEO12 вопросов -

Аналитика

Вопросы по Google Tag Manager, Google Analytics6 вопросов -

Контент

Вопросы по SEO-копирайтингу. Какими должны быть SEO-тексты4 вопроса -

Другое

Общие вопросы по SEO. Все, что связано с поисковой оптимизацией1 вопрос